Kafka y Amazon Bedrock: El Nuevo Eje de Conocimiento para la IA Empresarial

La evolución de la inteligencia artificial empresarial está marcada por una tendencia clara: el paso de modelos generalistas a arquitecturas contextuales, entrenadas con datos relevantes y actualizados en tiempo real. En este entorno, la combinación de dos tecnologías clave —Apache Kafka y Amazon Bedrock— permite crear sistemas que no solo generan respuestas, sino que lo hacen con fundamento, precisión y relevancia específica. Esta sinergia se está consolidando como una de las arquitecturas más prometedoras para la IA en entornos corporativos, especialmente en sectores que demandan decisiones automatizadas basadas en datos de flujo continuo.

Kafka como infraestructura de datos en movimiento

Apache Kafka es, desde hace años, el estándar de facto para la transmisión de datos en tiempo real. Se trata de una plataforma distribuida que permite capturar, almacenar y procesar flujos de eventos de forma eficiente, escalable y resiliente. Empresas de todos los sectores lo utilizan para centralizar los datos generados por aplicaciones, sensores, sistemas ERP, bases de datos y servicios cloud.

Su estructura basada en «topics» y «particiones» permite la ingestión y distribución masiva de eventos con baja latencia, lo que lo convierte en el candidato ideal para servir de pasarela hacia sistemas de inteligencia artificial que necesitan consumir datos actualizados y bien estructurados.

Amazon Bedrock y las bases de conocimiento vectorial

Amazon Bedrock, por su parte, permite desplegar modelos fundacionales de IA generativa sin necesidad de entrenarlos ni mantener infraestructuras complejas. Bedrock da acceso a modelos como Claude, Titan, Llama o Jurassic, todos preparados para generar texto, código, análisis o resúmenes en base a instrucciones humanas. Pero su verdadero valor se multiplica cuando se combina con bases de conocimiento, es decir, repositorios vectorizados de información relevante que se consultan en tiempo real a través de técnicas como RAG (Retrieval-Augmented Generation).

Estas bases no son simples almacenes de texto. Se construyen mediante embeddings, vectores matemáticos que representan el significado de cada documento, frase o fragmento, y se almacenan en motores como Amazon OpenSearch Serverless o Aurora PostgreSQL con capacidad vectorial.

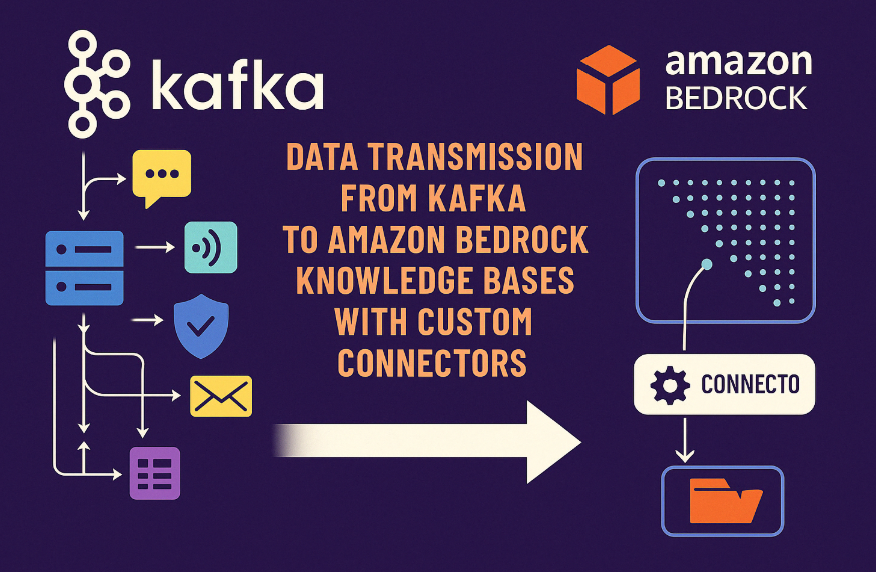

La integración: de eventos a conocimiento semántico

La arquitectura que conecta Kafka con Bedrock requiere una pieza intermedia: el conector personalizado. Este componente consume los mensajes de Kafka, los transforma en fragmentos comprensibles, y los vectoriza para alimentar la base de conocimiento. El proceso consta de varios pasos técnicos críticos:

- Consumo de eventos desde un topic de Kafka. Esto puede hacerse con lenguajes como Python o Java, empleando librerías como kafka-python o spring-kafka.

- Preprocesamiento de los datos, lo que incluye normalización, filtrado, eliminación de ruido, y segmentación en unidades semánticas útiles (por ejemplo, frases o párrafos).

- Vectorización a través del modelo Titan Embeddings, disponible en Bedrock. Esta operación transforma texto en vectores de cientos o miles de dimensiones, optimizados para búsquedas semánticas.

- Inserción de los vectores y sus metadatos en una base como OpenSearch Serverless.

- Activación de la consulta contextual desde un modelo fundacional (Claude, Titan, etc.), que combina los documentos relevantes con la solicitud del usuario y genera una respuesta rica en conocimiento.

Una arquitectura adaptativa y segura

A diferencia de los modelos generalistas entrenados con datos hasta una fecha determinada, esta arquitectura permite alimentar a la IA con contenido vivo, inmediato y procedente del propio negocio. Esto es fundamental para sectores como legal, financiero, sanitario o logístico, donde cada decisión debe estar basada en información actualizada, específica y muchas veces sensible.

El hecho de que la empresa controle tanto los datos como el pipeline de vectorización garantiza el cumplimiento normativo. La integración con IAM de AWS permite definir políticas precisas sobre quién accede a qué tipo de contenido, manteniendo la trazabilidad y la protección de datos que exige, por ejemplo, el Reglamento General de Protección de Datos (RGPD) o el Esquema Nacional de Seguridad (ENS).

EPISTEME-IA: una referencia española en arquitecturas contextualizadas

Uno de los casos más avanzados de implementación de este modelo es el de EPISTEME-IA, un proyecto español que ha desarrollado micromundos de conocimiento específicos para sectores como la logística, el sector asegurador, la prensa, la sanidad y la seguridad informática. En lugar de depender de un único modelo central, EPISTEME-IA ha diseñado entornos entrenados de forma vertical para cada campo, usando datos estructurados y flujos de eventos que llegan en tiempo real desde Kafka.

En logística, por ejemplo, los sensores de flotas envían constantemente datos de localización, estado mecánico y previsión de entrega. Estos eventos se procesan automáticamente y alimentan una base de conocimiento consultada por un LLM que asiste en decisiones operativas. En el sector asegurador, los siniestros entrantes se vectorizan y se comparan con resoluciones anteriores, permitiendo automatizar el proceso de respuesta o indemnización. En prensa, las noticias se analizan y reescriben según parámetros de estilo o enfoque editorial.

Este enfoque contextualizado no solo mejora la calidad de las respuestas, sino que reduce drásticamente el coste computacional y mejora la latencia en entornos productivos.

Escalabilidad, eficiencia y casos de uso concretos

La ventaja de esta arquitectura es su modularidad. Puede aplicarse en proyectos pequeños —como un asistente técnico entrenado con tickets de soporte— o en sistemas complejos de soporte a la decisión, donde los datos llegan desde múltiples orígenes y se consultan bajo demanda.

Ejemplos concretos incluyen:

- Monitorización de seguridad informática, donde logs en Kafka alimentan una IA que explica vulnerabilidades en lenguaje natural.

- Analítica de comportamiento en retail, donde datos de sensores de tienda se integran en tiempo real para adaptar campañas y mensajes.

- Salud digital, donde informes médicos se vectorizan y consultan para asistir a médicos en la toma de decisiones diagnósticas.

Conclusión: una IA con raíces en el dato y alas en la generación

El verdadero poder de la IA no está en su tamaño, sino en su relevancia. Conectar datos vivos a través de Kafka y permitir que Bedrock los interprete mediante técnicas como RAG transforma la generación de texto en un ejercicio de comprensión contextual profunda. Los modelos ya no hablan por sí mismos, sino que lo hacen desde la base del conocimiento estructurado que cada organización puede construir, proteger y evolucionar.

Empresas como EPISTEME-IA demuestran que este camino no solo es viable, sino altamente competitivo. El futuro no es un modelo más grande, sino uno más conectado, más entrenado en la realidad concreta y más útil para cada sector.